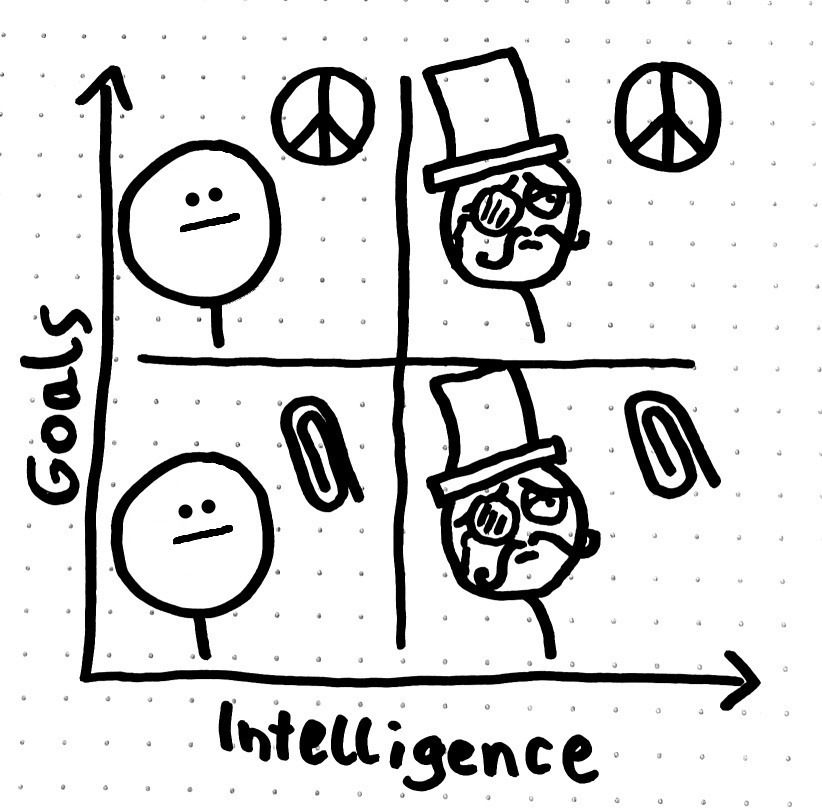

◎ Individuen praktisch jedes Intelligenzlevels können prinzipiell beliebige Ziele vefolgen. Besonders wichtig ist der untere rechte Quadrant: hier sehen wir, dass selbst sehr fortgeschrittene KIs sehr stupide Ziele verfolgen können, wie etwa die Herstellung von Büroklammern. Eine KI muss nicht automatisch beginnen höhere Ziele, wie etwa Weltfrieden, zu verfolgen, nur weil sie besonders gut darin ist ihre Ziele zu erreichen.

◎ Individuen praktisch jedes Intelligenzlevels können prinzipiell beliebige Ziele vefolgen. Besonders wichtig ist der untere rechte Quadrant: hier sehen wir, dass selbst sehr fortgeschrittene KIs sehr stupide Ziele verfolgen können, wie etwa die Herstellung von Büroklammern. Eine KI muss nicht automatisch beginnen höhere Ziele, wie etwa Weltfrieden, zu verfolgen, nur weil sie besonders gut darin ist ihre Ziele zu erreichen.

Grundlagen

Stell dir vor, du kaufst einen neuen, super-smarten Roboter-Staubsauger, der lernen kann. Dieser Roboter hat nur ein Ziel: dein Haus so sauber wie möglich zu machen.

Die Orthogonalitäts-These besagt nun zwei Dinge:

- Ziel und Intelligenz sind unabhängig voneinander: Egal wie schlau dein Roboter ist – ob er eher dümmlich ist oder ob er super-intelligent ist und jede noch so kleine Ecke deines Hauses kennt – sein Hauptziel bleibt immer dasselbe: das Haus sauber zu machen.

- Ein intelligentes System kann jedes Ziel verfolgen: Wenn du deinem Roboter ein neues Ziel gibst, z.B. die Pflanzen zu gießen, dann kann er das tun, egal wie intelligent er ist. Ein dümmerer Roboter könnte die Pflanzen vielleicht nur einmal am Tag gießen, während ein intelligenterer Roboter herausfinden könnte, wann und wie oft jede einzelne Pflanze Wasser braucht.

In einfachen Worten: Die Orthogonalitäts-These sagt uns, dass die Intelligenz eines Roboters (oder einer KI) nichts damit zu tun hat, welche Ziele er verfolgt. Ein Roboter kann sehr klug oder nicht so klug sein und trotzdem jedes beliebige Ziel verfolgen. Es ist wie bei Menschen: Ein kluger Mensch kann gute oder schlechte Absichten haben, genau wie ein nicht so kluger Mensch. Die Intelligenz bestimmt nicht das Ziel, sondern nur die Fähigkeit der KI, ihre Ziele zu erreichen.

Weiterführend

Die Orthogonalitätsthese besagt, dass der Grad der Intelligenz eines Agenten orthogonal - also im Wesentlichen unabhängig - zu seinen endgültigen Zielen ist: Beim maschinellen Lernen ist Intelligenz die Effizienz und Fähigkeit eines Algorithmus’, während das Ziel die Zielfunktion ist, die er optimieren soll. Die These besagt, dass man das eine ändern kann, ohne das andere zu beeinflussen.

In der Praxis bedeutet dies, dass bei der Entwicklung immer fortschrittlicherer KI-Systeme die bloße Steigerung ihrer “Intelligenz” (z. B. die Fähigkeit zu lernen, sich anzupassen oder Probleme zu lösen) nicht automatisch dazu führt, dass sie mit menschenfreundlichen Zielen in Einklang gebracht werden. Eine hochintelligente KI kann ein triviales oder sogar gefährliches Ziel verfolgen, wenn sie nicht angemessen eingeschränkt wird. Wenn ihre Zielfunktion nicht mit menschlichen Werten übereinstimmt, wird sie dennoch auf effektive Weise für dieses Ziel optimieren, ungeachtet der allgemeinen Auswirkungen.

Fortgeschritten

(Links in Englisch)

- https://arbital.com/p/orthogonality/

- https://philosophicaldisquisitions.blogspot.com/2014/07/bostrom-on-superintelligence-1.html

- https://www.fhi.ox.ac.uk/wp-content/uploads/Orthogonality_Analysis_and_Metaethics-1.pdf

- https://www.alignmentforum.org/tag/orthogonality-thesis

- Intelligence and Stupidity: The Orthogonality Thesis https://www.youtube.com/watch?v=hEUO6pjwFOo