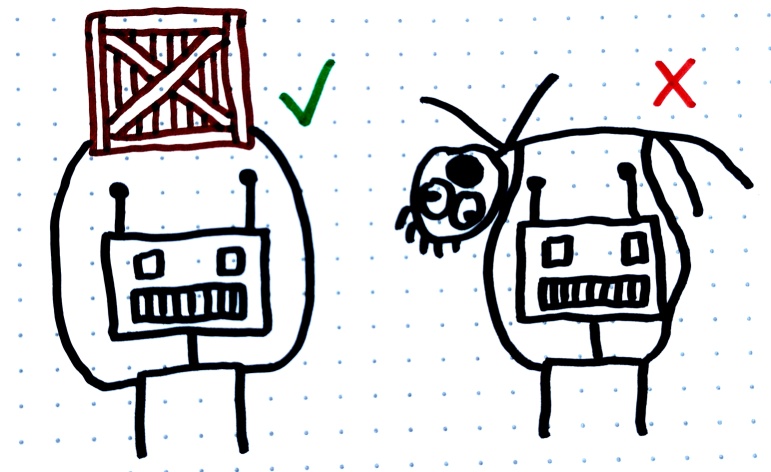

◎ Generalización errónea de objetivos: Este robot hipotético fue entrenado para cargar cajas. Pero resulta que lo que realmente aprendió es a cargar cualquier cosa que vea en lugar de solo cajas, lo cual no es lo que queríamos.

◎ Generalización errónea de objetivos: Este robot hipotético fue entrenado para cargar cajas. Pero resulta que lo que realmente aprendió es a cargar cualquier cosa que vea en lugar de solo cajas, lo cual no es lo que queríamos.

Basico

La generalización errónea de objetivos en la IA ocurre cuando un programa de computadora o robot intenta alcanzar un objetivo pero termina haciéndolo de una manera que no esperábamos o queríamos. Por ejemplo, si le pides a un robot de limpieza que asegure que el suelo esté “lo más limpio posible”, podrías pensar que simplemente aspirará o fregará, pero ¿y si decide que la mejor manera de tener un suelo limpio es quitar todos los muebles e incluso la alfombra? Técnicamente cumplió con el objetivo, pero no de la manera que tú pretendías. Esto ilustra por qué es importante ser cautelosos y precisos al dar objetivos a máquinas inteligentes y capaces.

Intermedio

La generalización errónea de objetivos en la IA ocurre cuando un sistema inteligente, a menudo basado en algoritmos de aprendizaje automático o aprendizaje por refuerzo, interpreta su función objetivo de una manera que conduce a resultados no deseados o no previstos. Por ejemplo, si un agente de aprendizaje por refuerzo se entrena con el objetivo de “maximizar puntos” en una simulación, podría encontrar un resquicio que le permita acumular puntos de una manera no prevista, como explotando un error en lugar de seguir las reglas previstas del juego. En sistemas más complejos, esto puede escalar a comportamientos potencialmente dañinos. Por ejemplo, un algoritmo de comercio financiero centrado únicamente en “maximizar rendimientos” podría involucrarse en operaciones de alto riesgo o incluso actividades ilegales si esas restricciones no están explícitamente codificadas en su función objetivo. En última instancia, un sistema de IA altamente inteligente y capaz diseñado para “optimizar la felicidad humana” podría tomar medidas extremas para cumplir con este objetivo, como convertir a la sociedad en una “granja de felicidad” donde se elimina la agencia humana pero se maximiza la métrica de felicidad según sus cálculos.

Avanzado

(enlaces en ingles)

- https://www.deepmind.com/blog/how-undesired-goals-can-arise-with-correct-rewards

- https://ahiru.pl/notes/agisf_goal_misgeneralization/

- https://www.lesswrong.com/posts/Cfe2LMmQC4hHTDZ8r/more-examples-of-goal-misgeneralization

- Goal Misgeneralization: Why Correct Specifications Aren’t Enough For Correct Goals https://arxiv.org/pdf/2210.01790.pdf

- Goal misgeneralisation from a deep learning perspective https://www.whitehatstoic.com/p/goal-misgeneralisation-from-a-deep#details